Robot.txt: Panduan Penting untuk Pengoptimalan Mesin Pencari

Robot.txt adalah file teks yang memberi tahu mesin pencari halaman web mana yang boleh dan tidak boleh dirayapi serta diindeks. Dengan mengoptimalkan file robot.txt, Anda dapat mengontrol akses ke situs web Anda dan memengaruhi visibilitasnya di hasil pencarian.

Manfaat Mengoptimalkan Robot.txt

- Meningkatkan kinerja situs web dengan mengurangi beban server melalui pembatasan perayapan halaman yang tidak perlu.

- Melindungi informasi sensitif atau area pribadi situs web dari pengindeksan.

- Menjaga konten berkualitas tinggi pada halaman web yang tepat dengan mengarahkan mesin pencari ke lokasi yang sesuai.

Cara Mengoptimalkan Robot.txt

- Identifikasi Halaman yang Tidak Akan Dirayapi: Tentukan halaman yang tidak ingin Anda muncul di hasil pencarian, seperti halaman login atau halaman yang berisi konten duplikat.

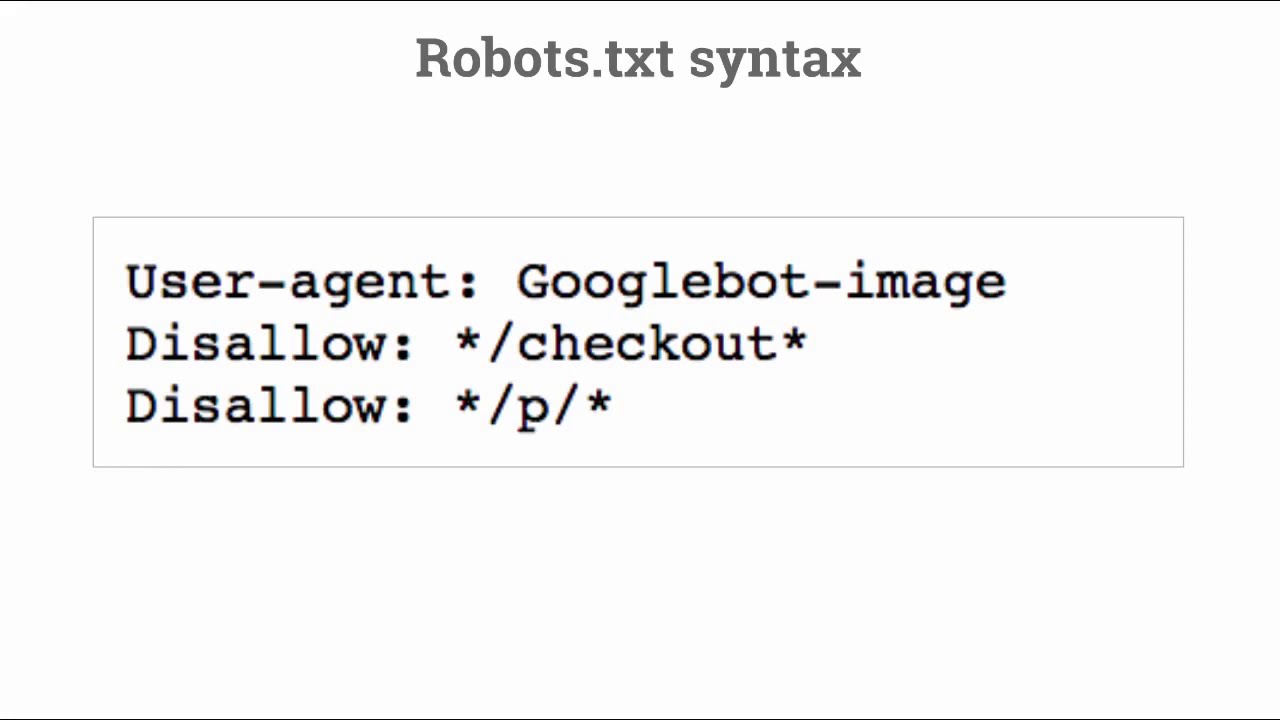

- Tambahkan Petunjuk ke Robot.txt: Gunakan perintah "Disallow" untuk mencegah mesin pencari merayapi halaman tertentu. Berikut contohnya:

User-agent: * Disallow: /page-to-disallow/ - Izinkan Akses ke Halaman Penting: Gunakan perintah "Allow" untuk mengizinkan mesin pencari merayapi halaman penting, seperti halaman beranda atau halaman produk. Berikut contohnya:

User-agent: * Allow: /page-to-allow/ - Blokir Perayap Berbahaya: Gunakan perintah "Crawl-delay" untuk membatasi frekuensi perayapan untuk perayap yang berpotensi berbahaya. Berikut contohnya:

User-agent: BadiBot Crawl-delay: 10 - Verifikasi Robot.txt Anda: Gunakan alat seperti Google Search Console untuk memverifikasi bahwa file robot.txt Anda berfungsi dengan benar.

Detail File

| Nama File | Ukuran | Tanggal | Download |

|---|---|---|---|

| robot.txt | 3.47 KB | 10 Jan 2025 | Unduh |

Dengan mengoptimalkan file robot.txt Anda, Anda dapat meningkatkan visibilitas situs web Anda di hasil pencarian, melindungi informasi sensitif, dan mengelola kinerja server Anda secara efisien.